Der EU AI Act ist die erste umfassende Gesetzgebung weltweit, die gezielt auf die Regulierung von Künstlicher Intelligenz (KI) abzielt. Die Verordnung wurde am 21. Mai 2024 verabschiedet und schafft einen klaren rechtlichen Rahmen für die Entwicklung, den Markteintritt und den Einsatz von KI-Systemen innerhalb der EU. Ziel des AI Acts ist es, das Vertrauen in KI-Anwendungen zu stärken und gleichzeitig ein hohes Schutzniveau für Gesundheit, Sicherheit und die Grundrechte der Bürger zu gewährleisten.

Der EU AI Act: Ein Überblick

Der EU AI Act folgt einem risikobasierten Ansatz: Die regulatorischen Anforderungen orientieren sich an dem Risiko, das von einem spezifischen KI-System ausgeht. Anwendungen mit potenziell höherem Risiko unterliegen strengeren gesetzlichen Vorgaben.

Entstehung und Kontext

Die Entwicklung des EU AI Acts wurde durch das wachsende Bewusstsein für die Chancen und Risiken von KI initiiert. Die EU sah die Notwendigkeit, einen Rechtsrahmen zu schaffen, der die Entwicklung innovativer KI-Anwendungen fördert und zugleich die Sicherheit und Rechte der Bürger schützt.

Die Europäische Kommission begann den Gesetzgebungsprozess, der durch die Zusammenarbeit des Europäischen Parlaments und des Rats der EU entscheidend geprägt wurde.

Der EU AI Act ergänzt andere zentrale EU-Gesetze, wie die Datenschutzgrundverordnung (DSGVO), und stellt sicher, dass Bürgerrechte und ethische Grundsätze in der EU gewahrt und gestärkt werden.

„Vertrauen ist bei der künstlichen Intelligenz nicht nur ein Pluspunkt, sondern eine Notwendigkeit. Mit diesen wegweisenden Regeln setzt die EU neue weltweite Standards, um sicherzustellen, dass KI vertrauenswürdig ist. Wir schaffen ethische Rahmenbedingungen für Technologie und gewährleisten, dass die EU wettbewerbsfähig bleibt.“

„KI ist ein Mittel, kein Selbstzweck. Diese Technologie birgt enormes Potenzial in Bereichen wie Gesundheit, Transport und Cybersicherheit, aber auch Risiken. Mit den heutigen Vorschlägen stärken wir die Position Europas als globales Zentrum für vertrauenswürdige KI und sichern, dass KI unseren Werten und Regeln entspricht.“

Hintergrund und Anstoß für den EU AI Act

Der EU AI Act entstand aus der dringenden Notwendigkeit, klare Rahmenbedingungen für den Umgang mit KI zu schaffen, um sowohl die Innovation zu fördern als auch grundlegende Rechte zu schützen. Angesichts der rasanten Verbreitung von KI und ihrer möglichen Auswirkungen war es unerlässlich, eine einheitliche Rechtsgrundlage für die Nutzung dieser Technologien in Europa zu entwickeln.

Akteure und Gesetzgebungsprozess

Die Entwicklung des EU AI Acts resultierte aus einem umfassenden Gesetzgebungsprozess, den die Europäische Kommission initiierte und der durch die Zusammenarbeit verschiedener Institutionen unterstützt wurde:

- Europäische Kommission: Als Initiator legte die Kommission den Gesetzentwurf vor und trieb den Prozess aktiv voran.

- Europäisches Parlament und Rat der EU: Diese Institutionen berieten den Vorschlag im Rahmen des ordentlichen Gesetzgebungsverfahrens und verabschiedeten ihn schließlich.

- Weitere Beteiligte: Institutionen wie der Europäische Wirtschafts- und Sozialausschuss, die Europäische Zentralbank und der Ausschuss der Regionen brachten Stellungnahmen und Empfehlungen ein, um die Ausrichtung des Gesetzes zu präzisieren.

Wichtige Hintergrundinformationen

Der EU AI Act folgt einem risikobasierten Ansatz, der für unterschiedliche Risiken verschiedene regulatorische Anforderungen an KI-Systeme festlegt:

- Ausdrückliches Verbot von Praktiken mit unannehmbarem Risiko: Der AI Act untersagt KI-Systeme, die ein hohes Risiko für die Sicherheit und Grundrechte darstellen, wie z. B. Systeme zur Verhaltensmanipulation und Social Scoring.

- Strenge Anforderungen für Hochrisiko-KI: Für Anwendungen, die als hochriskant gelten, bestehen strenge Vorschriften zur Konformitätsbewertung, zum Risikomanagement und zur Transparenz.

- Integration mit anderen EU-Vorschriften: Der AI Act ist eng mit bestehenden Gesetzen wie der DSGVO verknüpft, um das Schutzniveau weiter zu erhöhen.

Als umfassendes Regelwerk wird der EU AI Act die langfristige Entwicklung und Nutzung von KI in der EU prägen. Ziel ist es, KI verantwortungsvoll einzusetzen, europäische Werte zu schützen und gleichzeitig Innovationen zu fördern.

Aktueller Stand und geplante Durchsetzung des AI Acts

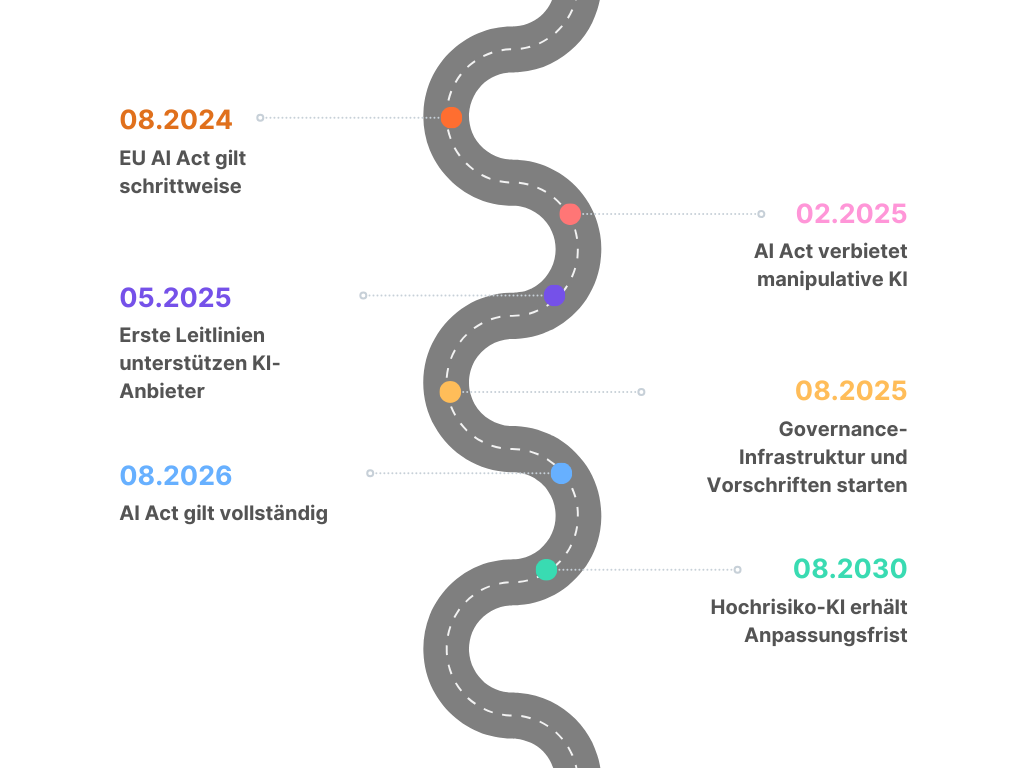

Der AI Act trat offiziell am 1. August 2024 in Kraft, jedoch wird die vollständige Anwendbarkeit stufenweise bis 2030 erreicht. Dieser gestaffelte Zeitplan ermöglicht es Unternehmen und Institutionen, sich schrittweise auf die neuen Vorgaben einzustellen.

Zeitplan für die Umsetzung

- 2. Februar 2025: Ab diesem Datum gelten die allgemeinen Bestimmungen des AI Acts, einschließlich des Verbots bestimmter KI-Praktiken wie Social Scoring und manipulativer Systeme.

- 2. Mai 2025: Die ersten Codes of Practice werden zur Verfügung stehen, um den Anbietern von KI-Systemen die frühzeitige Konformität zu erleichtern.

- 2. August 2025: Die Infrastruktur für Governance und Konformitätsbewertungen wird etabliert, und die Vorschriften für die notifizierten Stellen sowie Anbieter von general-purpose AI models treten in Kraft.

- 2. August 2026: Ab diesem Datum gilt der AI Act in vollem Umfang.

- 2. August 2030: Für Hochrisiko-KI-Systeme in öffentlichen Bereichen gilt bis zu diesem Datum eine verlängerte Anpassungsfrist, um die vollständige Konformität zu erreichen.

Mögliche Änderungen und Erweiterungen

Der AI Act sieht vor, dass die Europäische Kommission durch delegierte Rechtsakte Anpassungen vornehmen kann, um mit technologischen Fortschritten Schritt zu halten. So könnte die Liste der Hochrisiko-KI-Systeme in Anhang III erweitert oder angepasst werden. Weitere Anpassungen könnten neue Anforderungen an technische Dokumentationen und Konformitätsbewertungsverfahren umfassen.

Zusätzliche Anpassungen umfassen:

- Regelmäßige Evaluierung: Die Europäische Kommission wird den AI Act bis spätestens 2. August 2031 evaluieren und potenzielle Änderungen vorschlagen.

- Integration neuer Benchmarks: Festlegung von Benchmarks zur Bewertung von general-purpose AI models wird zunehmend an Bedeutung gewinnen.

- Ergänzende EU-Behörden: Die Einrichtung einer spezialisierten EU-Agentur könnte in Betracht gezogen werden, die sich ausschließlich mit der Durchsetzung und Weiterentwicklung des AI Acts befasst.

Umsetzung und Anpassungspflicht für Unternehmen

Unternehmen, die KI-Systeme entwickeln oder nutzen, sind verpflichtet, ihre Systeme gemäß den Vorgaben des AI Acts zu klassifizieren und anzupassen. Dazu gehören Maßnahmen zur Einhaltung der Risikoklassifizierung, Konformitätsbewertungen, Risikomanagement und Transparenzanforderungen.

Die wichtigsten Schritte für die Umsetzung sind:

- Klassifizierung der KI-Systeme: Unternehmen müssen alle KI-Systeme gemäß dem AI Act auf ihr Risikopotenzial hin prüfen und klassifizieren.

- Erfüllung risikospezifischer Anforderungen: Je nach Risikoklasse sind spezifische Konformitätsbewertungen und Risikomanagementprozesse erforderlich.

- Schulung und Dokumentation:Unternehmen sollten Mitarbeitende zu den neuen Anforderungen schulen und die Konformität ihrer Systeme kontinuierlich dokumentieren.

Verhaltenscodex für General-purpose AI Modelle

Für Anbieter von General-purpose AI models, die in verschiedenen Bereichen Anwendung finden, ergeben sich besondere Herausforderungen.

Allgemeine KI-Modelle können eine Vielzahl von Aufgaben erfüllen und bilden zunehmend die Grundlage vieler KI-Systeme in der EU. Einige dieser Modelle könnten daher systemische Risiken bergen, besondere wenn sie sehr weit verbreitet sind.

Um eine sichere und vertrauenswürdige Nutzung dieser Modelle zu gewährleisten, führt der AI Act Regeln für deren Anbieter ein. Dazu gehören Vorgaben zu Transparenz und urheberrechtlichen Aspekten.

Die Regeln des AI Acts für Allgemeine KI treten im August 2025 in Kraft. Das AI Office fördert die Erstellung eines Verhaltenskodexes, um diese Regeln näher auszuführen. Der Kodex soll ein zentrales Werkzeug für Anbieter sein, um beispielsweise aktuelle Best Practices zu integrieren.

Die Umsetzung des AI Acts ist ein fortlaufender Prozess, der ständige Anpassungen und die Überwachung neuer regulatorischer Anforderungen erfordert.

Klassifizierung von KI-Systemen im EU AI Act

Der risikobasierte Ansatz des Acts legt fest, dass sich Anforderungen und Einschränkungen von KI-Systemen nach dem Risiko richten, das von ihnen ausgeht. Der EU AI Act definiert vier zentrale Risikoklassen:

- Unannehmbares Risiko: Systeme mit unannehmbarem Risiko sind innerhalb der EU verboten. Dazu zählen Technologien, die Personen manipulieren oder Social Scoring betreiben.

Ein berühmtes Beispiel ist der Deepfake-Skandal mit Vitali Klitschko. - Hohes Risiko: Systeme mit erheblichen Auswirkungen auf Gesundheit, Sicherheit oder Grundrechte werden als Hochrisiko-KI-Systeme eingestuft. Diese unterliegen strengen Anforderungen.

Aktuelles Beispiel: Autonome Fahrzeuge – Tesla. Unfälle nehmen weiter zu - Begrenztes Risiko: Systeme mit begrenztem Risiko unterliegen spezifischen Transparenzanforderungen. Nutzer müssen darüber informiert werden, dass sie mit KI interagieren.

Beispiel: Personalisierte Werbung - Minimales Risiko: Systeme mit minimalem Risiko, wie private Automatisierungsanwendungen, unterliegen keinen besonderen Anforderungen.

Der AI Act enthält eine Liste von Hochrisiko-Anwendungsbereichen in Anhang III, wie:

- Biometrische Identifizierungssysteme, z. B. Gesichtserkennung zur Strafverfolgung.

- KI in kritischen Infrastrukturen, wie in Strom- und Verkehrssystemen.

- KI im Bildungswesen, etwa zur Bewertung von Schülerleistungen.

- Arbeitsbezogene KI-Systeme, wie Anwendungen zur Kandidatenauswahl oder Leistungsbewertung.

Konkrete Sanktionen bei Verstößen gegen das KI-Gesetz

Für Verstöße gegen das Gesetz sind strenge Strafen vorgesehen. Die Höhe der Sanktionen richtet sich nach der Art des Verstoßes und der Unternehmensgröße, um die Einhaltung der Vorschriften sicherzustellen.

Übersicht über die Sanktionen

- Geldbußen bei schwerwiegenden Verstößen: Bei Verstößen gegen grundlegende Verbote, wie Social Scoring, können Geldbußen bis zu 35 Millionen Euro oder 7 % des weltweiten Jahresumsatzes verhängt werden.

- Geldbußen für Verstöße gegen Hochrisiko-Vorgaben: Werden die Anforderungen für Hochrisiko-KI-Systeme nicht erfüllt, drohen Bußen von bis zu 15 Millionen Euro oder 3 % des Jahresumsatzes.

- Besondere Regelungen für KMU: Für kleine und mittlere Unternehmen gelten reduzierte Höchstbeträge bei Geldbußen.

Unterschiede zwischen DSGVO und AI Act

Die DSGVO und der EU AI Act sind zwei wichtige europäische Gesetzgebungen, die den Schutz von Personen im digitalen Zeitalter sichern. Beide haben jedoch unterschiedliche Schwerpunkte und Ziele.

Unterschiedliche Zielsetzungen

- DSGVO: Fokussiert auf den Schutz personenbezogener Daten und die Wahrung der Privatsphäre.

- AI Act: Zielt auf die sichere und transparente Nutzung von KI-Systemen und den Schutz der Bürgerrechte ab.

Fazit

Der EU AI Act ist die erste umfassende Verordnung zur Regulierung von KI in Europa. Der risikobasierte Ansatz kategorisiert KI-Anwendungen und stellt abgestufte Anforderungen an Sicherheit, Transparenz und Konformität. Hochrisiko-KI-Systeme unterliegen besonders strengen Vorschriften, während Praktiken mit unannehmbarem Risiko verboten sind. Der Act fordert Unternehmen dazu auf, umfassende Compliance-Maßnahmen zu ergreifen und stellt sicher, dass KI in Europa den ethischen und rechtlichen Grundwerten der EU entspricht.

Quellen

- Bundesregierung: Überblick zum EU AI Act

- Baden-Württemberg Datenschutz: Datenschutz und KI

- REGULATION (EU) 2024/1689 des Europäischen Parlaments und des Rates vom 13. Juni 2024

- EU AI Act – Vollständige Gesetzgebung

- Coordinated Plan on Artificial Intelligence (2021)

- White Paper on AI (2020)

- EU Data Governance Act

- High-Level Expert Group on AI: Ethics Guidelines for Trustworthy AI